过拟合的问题

过拟合(Overfitting)是指机器学习模型在训练数据上表现得过于优秀,以至于在未见过的新数据上表现不佳的现象。过拟合发生时,模型会过度适应训练数据中的噪声和细节,而忽略了真正的数据模式和一般性质,从而导致泛化性能下降。

针对上方的线性回归、逻辑回归等,将它们应用到某些特定的机器学习应用时,会遇到过拟合(over-fitting)的问题,可能会导致它们效果很差。

过拟合的特征包括:

- 训练集上表现良好,测试集上表现较差: 模型在训练数据上的预测非常准确,但在新的、未见过的数据上预测不如预期。

- 模型复杂度过高: 过拟合模型可能具有过多的参数或过于复杂的结构,以致于能够很好地拟合训练数据中的每个样本。

- 小样本噪声: 模型可能在训练数据中的噪声点上表现出较高的准确率,而在真正的数据模式上表现不佳。

- 参数值过大: 过拟合模型的参数值可能在训练过程中变得非常大,以适应训练数据中的小细节。

为了应对过拟合,可以采取以下一些方法:

- 使用更多的训练数据: 增加训练数据的数量可以帮助模型更好地学习数据的一般性质,减少过拟合的可能性。

- 简化模型: 降低模型的复杂度,可以通过减少参数数量、降低多项式次数等方式来避免过拟合。

- 正则化: 引入正则化项,如L1正则化或L2正则化,可以限制模型的参数大小,防止过拟合。

- 特征选择: 选择与问题相关的重要特征,避免使用过多无关的特征。

- 交叉验证: 使用交叉验证来评估模型的性能,确保其在多个数据子集上的表现都良好。

- 集成方法: 使用集成方法如随机森林、梯度提升等,可以减少模型的过拟合倾向。

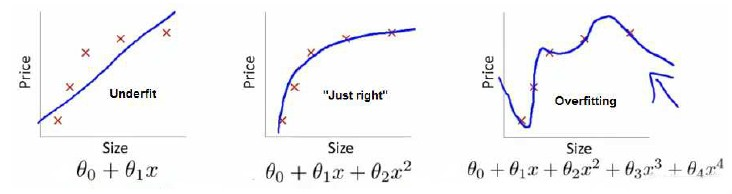

回归问题

第一个模型是一个线性模型,欠拟合

第三个模型是一个四次方的模型,过于强调拟合原始数据,而丢失了算法的本质:预测新数据。

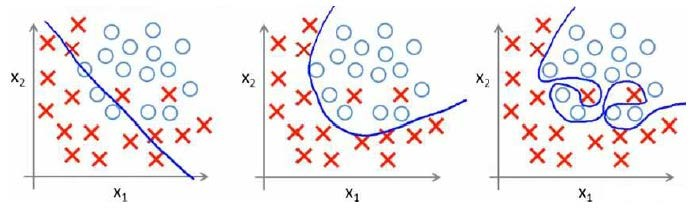

分类问题

就以多项式理解, 的次数越高,拟合的越好,但相应的预测的能力就可能变差。

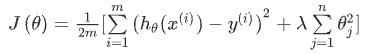

代价函数

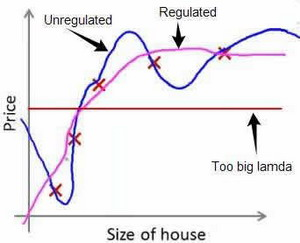

从之前的事例中看出,正是那些高次项导致了过拟合的产生,所以如果我们能让这些高次项的系数接近于0的话,我们就能很好的拟合了。 所以要做的就是在一定程度上减小这些参数θ 的值,对某些参数进行惩罚,这就是正则化的基本方法。

在逻辑回归等机器学习算法中,常用的正则化代价函数有L1正则化和L2正则化。教程中介绍的是L2正则化;代价函数同样由原始的损失函数和正则化项组成,但正则化项使用参数向量中的平方和作为正则化项,以降低参数的大小。正则化参数 λ 的选择影响了正则化项对模型的影响程度。较大的 λ 会使模型更加倾向于选择较小的参数值,从而降低过拟合的可能性。

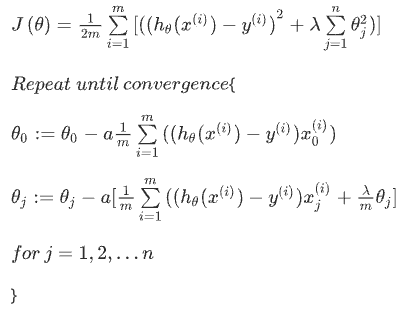

所以修改之后的代价函数为

其中λ又称为正则化参数(Regularization Parameter

正则化线性回归Regularized Linear Regression

对于线性回归的求解,之前推导了两种学习算法:一种基于梯度下降,一种基于正规方程。

正则化梯度下降

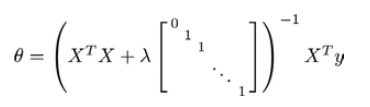

正则化正规方程

正则化逻辑回归Regularized Logistic Regression

之前的课程已经学习过两种优化算法:

- 梯度下降法来优化代价函数

- 高级的优化算法,这些高级优化算法需要自己设计代价函数