内容纲要

一次性让大模型“做完一切”,常常得到含混、难复现、不可调试的结果。提示链(Prompt Chaining)通过把复杂任务拆成若干可验证的小步骤,并结合结构化输出与可观测性,显著降低幻觉与错误累积,提升稳定性与交付质量。本文给出可落地的设计原则、流程清单与常见排错点,适合需要稳定输出的研发、产品与内容团队。

TL;DR

- 核心:把复杂任务拆成“单一职责”的有序步骤,用结构化数据在步骤间传递。

- 关键:独立子任务并行、依赖任务顺序执行;关键节点做验证与重试。

- 手段:可观测性(记录输入/输出)、缓存(复用相同输入)、分级模型(小模型做易事)。

- 边界:简单任务不必上链;当“描述里频繁出现‘然后/同时’”,应考虑拆分。

- 实践:JSON 为首选中间格式;为每步写一句“验收条件”;失败要能回滚与降级。

- 延伸:与并行化、上下文工程配合使用效果最佳。

是什么:提示链的核心与术语澄清

提示链(Prompt Chaining)是把复杂任务拆成多个连续步骤的执行模式,前一步的输出作为下一步的输入,亦称“管道模式”。它强调:

- 单一职责:每一步只做一件事,便于验证与替换

- 结构化输出:用 JSON/XML 传递数据,降低二义性

- 可观测性:记录每步输入/输出,便于定位与复盘

基础示意(顺序依赖场景):

输入 → [提示1 + LLM] → 输出1 → [提示2 + LLM] → 输出2 → 最终结果说明:

- 适用于存在明确依赖的多步推理或加工;

- 结合并行化可进一步提速:独立子任务并行、依赖环节顺序;

- 配合上下文工程,整体质量显著优于“单次长提示”。

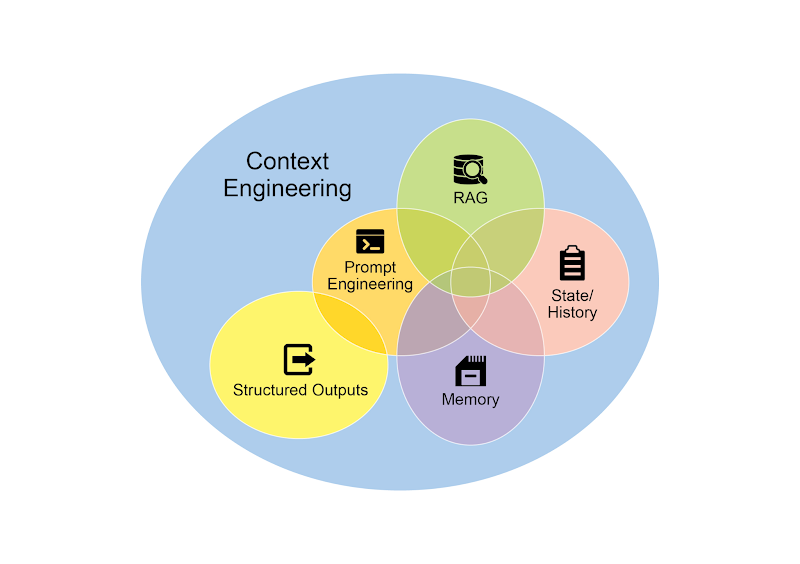

配图(上下文工程是质量前提):

读图要点:高质量上下文(系统提示、工具输出、历史对话、用户画像)是稳定输出的“地基”。

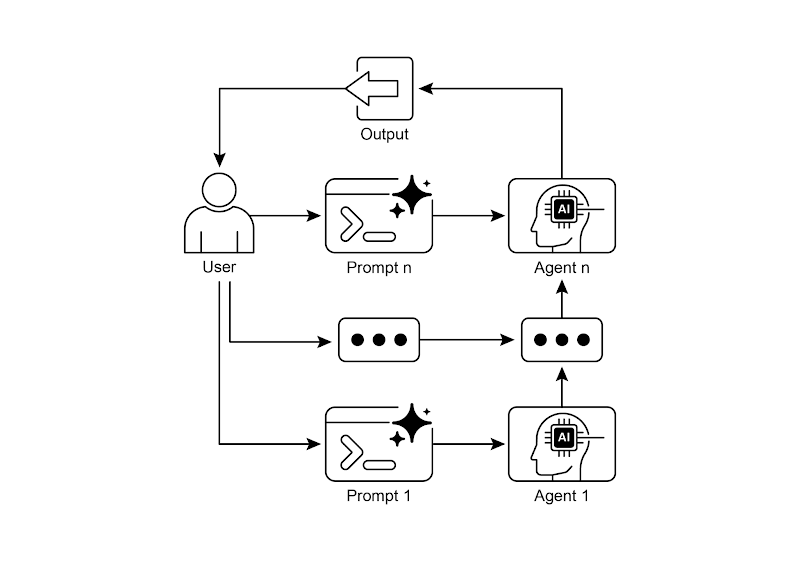

提示链结构示意:

读图要点:每个步骤既可复用也可单测;中间结果可审阅、回放与修正。

术语速查:

- 结构化输出:在步骤间传 JSON,避免自然语言解析误差

- LCEL:LangChain 表达式语言(用管道符 <code>|</code> 串接模块)

- 上下文工程:构建完整信息环境,而非只调词令句

为什么:从“单次大而全”到“可控小步骤”

单一提示常见问题:

- 指令被忽视、上下文丢失,导致答非所问

- 错误累积难以定位,复盘成本高

- 输出不可复现、难以 A/B 与版本化

提示链的优势:

- 每步聚焦一个子任务,易于校验与替换

- 可以查看中间结果,便于纠错与人工干预

- 易于做性能与成本优化(并行、缓存、分级模型)

适用边界:

- 适合:多步推理、工具调用链、高失败率环节需要验证的流程

- 不必:一次性问答、极短的结构化抽取、无依赖的简单任务

怎么做:可落地流程与清单

1)拆分步骤(单一职责)

- 规则:每步用一句话能清楚描述;若出现“然后/同时”,继续拆

- 产物:步骤列表 + 每步“输入/输出/验收条件”

2)定义中间数据(结构化输出)

- 首选 JSON:定义字段、类型、可选值与必填项

- 关键步骤添加“数据完整性校验”与“格式校验”

3)并行 + 顺序混合

- 独立子任务并行(检索、信息提取、评审等)

- 依赖环节顺序执行(整合、生成最终稿)

- 注意合并策略:冲突优先级、打分与去重

4)错误处理与重试

- 关键步骤:验证失败 → 定向重试(仅重跑该步)

- 失败降级:返回最小可用结果或触发人工审阅

- 记录失败样本,作为提示与规则迭代素材

5)可观测性与缓存

- 记录每步输入/输出 + 成本与时延,便于审计与优化

- 对相同输入启用缓存,避免重复计算

6)分级模型选择

- 简单规则/提取:小模型;复杂生成/推理:大模型

- 在链上混用模型,优化性价比

参考流程(内容创作):

主题 → 生成选项 → 用户选择 → 生成大纲 → 逐段撰写 → 润色 → 完整文章运行前提与提醒:

- 需明确目标读者与风格;

- 为“逐段撰写”定义统一术语表与样例;

- 在“完整文章”前加一致性与事实核查。

对比与取舍:与并行化、上下文工程如何配合

- 提示链 vs 并行化:有依赖链用提示链,独立任务用并行化;实际常混用

- 提示链 vs 上下文工程:提示链是执行模式;上下文工程是信息组织方式

- 组合建议:

- 先用上下文工程把信息准备好

- 独立收集/提取并行执行

- 依赖整合用顺序提示链

- 关键节点强校验 + 重试

常见错误与排错清单

- 自然语言在链间传递,造成歧义 → 用 JSON 并校验字段

- 所有步骤都用大模型 → 分级选型,小模型做易事

- 无可观测性 → 记录输入/输出、成本与耗时;保留失败样本

- 并行合并混乱 → 先定冲突处理与去重策略,再落地

- 无失败重试与降级 → 关键步骤要可重跑,并提供最小可用结果

- 无术语与样例 → 链上风格不一致;准备术语表与黄金样例

FAQ

- 问:提示链会增加时延吗?

答:会。通过并行独立子任务、缓存相同输入、分级模型,可把总耗时与成本控制在可接受范围。 - 问:需要几步合适?

答:一般 3–5 步。以“一步一句话”描述为准绳,出现“然后/同时”就再拆。 - 问:中间步骤失败怎么办?

答:关键步骤做验证与定向重试;必要时降级或触发人工审阅。 - 问:与并行化是什么关系?

答:链上依赖用顺序,独立环节并行,混用最佳。 - 问:如何保证链间传递的准确性?

答:统一使用结构化格式(JSON/XML),并在关键节点添加数据完整性检查。

延伸阅读与引用

- LangChain LCEL(表达式语言):https://python.langchain.com/docs/expression_language/

说明:用于构建提示链的核心语法与编排方式 - LangGraph(有状态图):https://langchain-ai.github.io/langgraph/

说明:支持状态管理与循环计算 - Prompt Engineering Guide - Chaining:https://www.promptingguide.ai/techniques/chaining

说明:分步处理的优势与典型应用(如多阶段摘要) - Google Vertex AI Prompt Optimizer:https://cloud.google.com/vertex-ai/docs/generative-ai/learn/prompts/prompt-optimizer

说明:企业级提示优化与治理工具

总结

提示链把“难而大”的问题拆成“稳而小”的步骤:结构化输出降低歧义,可观测性提升可控性,并行+顺序的混合保证效率与质量。为关键步骤加验证与重试,再用上下文工程夯实信息底座,即可在复杂流程中持续交付稳定、可复现的结果。接下来,建议结合你的真实流程,先把“验收条件”写清,再逐步上链。